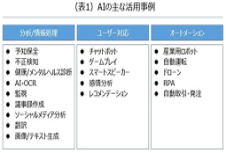

| ●デジタル社会での倫理観① AIの活用と倫理 |

| ●デジタル社会での倫理観① AIの活用と倫理 |

| AI活用に関する倫理的課題が日経新聞等で多様に論じられている。 例えば9年前に議論された米小売大手のターゲットマーケティングの事例。 |

|

某小売大手は客の買い物履歴を分析し、妊娠初期の女性がマグ ネシウムなど特定のサプリや無香料のせっけんをよく買うことを突き止めた。この知見をもとに顧客リストから妊婦(の可能性の高い人)を洗い出し、出産後を見越して紙おむつなど赤ちゃん用品のクーポンを送り始めた。 ところが、その中の一人に女子高生がいた。クーポンを見た父親は「高校生の娘に変なモノを送るな」と激怒したが、実はその子は妊娠していた。毎日顔をあわせる家族より先に、購買履歴データのほうが妊娠というデリケートな事実を察知したのだ。一家にとっては極めて後味の悪い出来事だったに違いない。 便利なAIは、薄気味悪いAIにもなる。人々の安全や健康を守るAIは、身近な人間関係を壊しかねないAIにもなる。 |

| 日本でも2年ほど前に、リクルートキャリアが運営する就活支援サービス「リクナビ」がAIを使って学生の内定辞退率を算出し、企業に販売していた問題が大きな波紋を広げたことがあった。 リクナビなどの就活サイトは数社に限られ、現在はその利用を前提に就活が成り立っており、就活生がサイト側の運営方針に「同意しない」ことを選択するのは難しい。そうした優越的地位を利用して個人情報を活用し、辞退率データを年間400万~500万円で企業に販売していたリクルートキャリアの責任は厳しく問われたことがあった。 またHRtechでは、リソースとなるデータの偏りによって、労働者等が不当に不利益を受ける可能性が指摘されている。このため、AIの活用について、企業が倫理面で適切に対応できるような環境整備を行うことが求められる。 |

ほかに欧米の多くのシステムで白人より非白人の顔認証の精度が低いと報告されており、実際に他人と取り違えられて無実の黒人が誤認逮捕される事件も起きている。そこでボストンやサンフランシスコをはじめ、当局による監視目的の顔認証を条例で制限する自治体も増えてきたというような話もある。 AIの情報リソースとなるデータやアルゴリズム(計算方式)にはバイアスが含まれている可能性があるため、AIによる判断に関して企業が果たすべき責任、倫理の在り方も課題となる。 |

|

|

|

| 4月下旬に欧州連合(EU)の欧州委員会が公表したAIの規制案でも、法執行を目的とする公共空間での顔認証は監視社会を招きかねないという理由で「禁止」の対象になった。企業の採用選考にAIを使う人事テックも厳しい規制に服する「ハイリスク」カテゴリーに分類された。 公正で中立的に見えるAIだが、実際は学習するデータセットの偏りや、アルゴリズムを書く人の(多くの場合は無意識の)バイアスの投影によって、AIの判断に偏見や差別が忍び込む恐れのあるのは周知の事実である。 |